Una breve guía para la cosmología

¿Confundido por la inflación y el fondo cósmico de microondas (CMB en inglés) ? ¿Perplejo por la energía oscura y la materia oscura? ¿Quieres saber que pasó después del Big Bang? Entonces, continúa leyendo para saber cómo encaja todo.

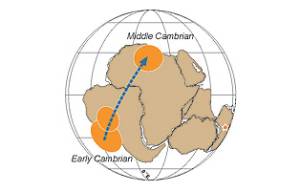

Edwin Hubble hizo los dos descubrimientos más importantes en la cosmología. Primero, demostró que muchas nebulosas son galaxias o “universos isla”, más allá de los límites de la Vía Láctea, nuestra galaxia.

Luego, trabajando con colegas en el observatorio Mount Wilson, descubrió que esas galaxias se están alejando unas de otras. El universo se expande.

En la segunda mitad de la década de los años 20 del siglo pasado, Hubble estaba interesado principalmente en medir la distancia a las galaxias. Estaba intrigado por un descubrimiento hecho en la década anterior por Vesto Slipher, un astrónomo que trabajaba en el observatorio Lowell, en Flagstaff, Arizona.

Slipher había estado trabajando con un telescopio refractor de 61 cm que tenía un instrumento nuevo llamado espectrógrafo, el cual podía tomar fotografías de los espectros de objetos celestes débiles con tiempos de exposición de varias noches si fuera necesario. Entre los objetos que Slipher estudió habían unos cuantos de la familia de las conocidas por aquel entonces como nebulosas, que Hubble más tarde descubrió que eran galaxias externas a la nuestra.

En 1925, cuado Hubble estaba comenzando a medir distancias a las galaxias, Slipher había medido 41 de esos espectros, y había encontrado que sólo dos de ellos (incluyendo el de la nebulosa de Andrómeda) mostraban desplazamientos al azul, mientras que los 39 restantes mostraban desplazamientos al rojo. Éste fue el límite de lo que podía hacer con el telescopio del que disponía, pero la evidencia apuntaba que las galaxias que parecían más grandes y más brillantes tenían desplazamientos al rojo menores.

La deducción obvia fue que las galaxias que parecían más grandes y brillantes estaban más cerca de nosotros – así que Hubble intuyó que la medida de sus desplazamientos al rojo podría ser una forma de medir la distancia a esas galaxias, y propuso a su colaborador Milson Humason probar la idea con un telescopio de 250 cm de diámetro. Humason midió los desplazamientos al rojo, mientras Hubble estimaba las distancias a las mismas galaxias usando otros métodos.

EL DESPLAZAMIENTO AL ROJO

Al principio de la década de 1930, Hubble y Humason habían hecho suficientes observaciones para demostrar que la relación entre los desplazamientos al rojo y las distancias era tan simple como podía ser: el desplazamiento al rojo es proporcional a la distancia, o como había propuesto Hubble, la distancia proporcional al desplazamiento al rojo.

Ésta es ahora conocida como la Ley de Hubble. Significa que si una galaxia tiene el doble de desplazamiento al rojo que otra, está dos veces más lejos que ésta última. Una vez que las distancias a algunas galaxias cercanas habían sido medidas por otros medios, la relación entre la distancia y el desplazamiento al rojo podía ser calibrada, y las distancias a otras galaxias, mucho más lejos en el universo, podían ser medidas simplemente midiendo sus desplazamientos al rojo.

De hecho, esta simple ley sólo se aplica con exactitud a las galaxias relativamente cercanas, y una relación más sútil se aplica a todo el universo, pero ésto no resta importancia al descubrimiento de Hubble.

El mismo Hubble no estaba interesado en por qué la luz de las galaxias mostraba un desplazamiento al rojo. Lo que le preocupaba era, independientemente de su causa, cómo el desplazamiento al rojo podía usarse para medir distancias. Pero la propuesta natural al principio fue que los desplazamientos al rojo se debían al efecto Doppler.

Si esto fuera así, significaba que sólo dos galaxias están acercándose a nosotros, y el resto se están alejando – no individualmente, sino como miembros de cúmulos como el de Virgo. Enseguida se vio que ,sin embargo, la recesión de las galaxias no era debida al movimiento de las galaxias y los cúmulos en el espacio.

La teoría de la relatividad de Albert Einstein, que había terminado en 1915, describía cómo el espacio mismo podía ser curvado en presencia de materia, como una goma estirada con un objeto pesado sobre ella. Las ecuaciones también describían cómo el espacio podía estirarse como un todo, pero en 1915 las nebulosas todavía no habían sido siquiera identificadas como otras galaxias, y Einstein había dejado esto como un truco matemático sin ningún significado físico.

Después del descubrimiento de la relación desplazamiento al rojo – distancia, Einstein y otros matemáticos se dieron cuenta de que esto era exactamente lo que sus ecuaciones describían – el espacio mismo estirándose y llevándose consigo los cúmulos de galaxias. Éste fue el comienzo de la cosmología moderna.

El desplazamiento al rojo cosmológico no es un efecto Doppler. No está provocado por el movimiento de las galaxias a través del espacio, sino por el estiramiento del espacio entre las galaxias durante el tiempo que le lleva a la luz ir de una galaxia a otra, estirando también la longitud de onda de la luz (haciéndola mayor).

Las galaxias se mueven a través del espacio, produciendo el efecto Doppler en sus espectros, pero éste se suma o se resta al desplazamiento al rojo cosmológico (aquel que proviene del estiramiento del espacio entre las galaxias), que es por el que por ejemplo, Andrómeda muestra un desplazamiento al azul. Se está moviendo hacia nosotros a través del espacio más rápido que la expansión del espacio entre nosotros y Andrómeda. Pero excepto para las galaxias más cercanas, el desplazamiento al rojo cosmológico predomina sobre el resto de las contribuciones.

La forma habitual de visualizar esto, es imaginar un balón de goma perfectamente esférico, con puntos dibujados sobre ésta. Si el balón se infla y se expande, todos los puntos se alejarán unos de otros, no debido a que se estén moviendo, sino debido a que la goma se está moviendo.

Y, crucialmente, no habrá ningún centro en la expansión – desde cualquier punto observarás que los otros puntos se están alejando, exactamente en la línea de la ley de Hubble. De nuevo, vemos que la Vía Láctea no tiene nada de especial respecto a otras galaxias. La visión de la expansión del universo sería la misma desde cualquier galaxia del universo.

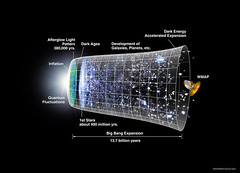

EL BIG BANG

La primera consecuencia de este descubrimiento fue que si el universo se está haciendo cada vez más grande, tuvo que ser más pequeño en el pasado. Tuvo que haber un instante en el que las galaxias estaban todas juntas.

Si todavía vas más atrás en el tiempo, llegaría un instante en el que todo el universo estaba concentrado en un punto. Usando la Ley de Hubble y la última calibración de la relación desplazamiento al rojo-distancia, podemos calcular que esto ocurrió hace aproximadamente 14 000 millones de años.

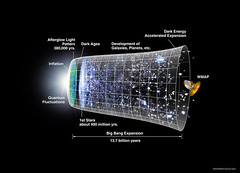

Esto es lo que llevó a la idea de que el universo emergió a partir de una “bola de fuego caliente”, el Big Bang, y se ha estado expandiendo y enfriando desde entonces. Pero el modelo cosmológico del Big Bang sólo fue tomado en serio a partir de la década 1960 del siglo pasado, cuando los radioastrónomos Arno Penzias y Robert Wilson descubrieron una señal de radio de ruído que identificaron como el eco remanente del Big Bang.

Esta radiación de fondo se encuentra en el rango de frecuencias de las microondas, y procede de todas las direcciones del espacio, y por tanto, se la conoce con el nombre de radión de fondo cósmico de microondas, o simplemente, radiación de fondo cósmica. Cósmica porque procede de todas las direcciones del espacio, y de fondo, porque la detectamos como una señal de ruido.

La radiación electromagnética de origen térmico, emite en un rango de frecuencias (su espectro de emisión) que depende sólo de la temperatura, lo que se conoce como radiación de cuerpo negro. Así, si el máximo de radiación emitida se encuentra en la zona del espectro electromagnético correspondiente al color blanco-amarillo del sol, la temperatura correspodiente será de unos cuantos miles de grados en la escala Kelvin; un trozo de hierro al rojo vivo está más frío, la emisión invisible infrarroja más fría aún, y así sucesivamente.

Similarmente, los objetos que emiten fundamentalmente en el ultravioleta o en rayos-X son mucho más calientes que el Sol. La temperatura del fondo cósmico de microondas, sin embargo, es de tan sólo, 2,7 K, -270,5 ºC. Pero se encuentra extendida por todo el universo.

RADIACIÓN DE FONDO CÓSMICO DE MICROONDAS

La explicación de la existencia del fondo cósmico de microondas es que el universo empezó siendo una “bola de fuego caliente”, mucho más caliente que una estrella. A medida que se fue expandiendo, esa “bola de fuego” se fue enfriando, como un gas expandiéndose al salir de un “spray aerosol”.

Al principio, los fotones (radiación) colisionaban con las partículas cargadas del mismo modo que lo hacen en el interior del Sol. Pero cuando el universo entero se enfrió lo suficiente, se formaron los primeros átomos neutros, y la radiación comenzó a viajar libremente por el espacio, como escapa de la superficie de una estrella.

Inevitablemente, esto ocurrió cuando la temperatura de todo el universo era aproximadamente la misma que en la superficie de una estrella que observamos en el cielo actualmente, unos cuantos miles de grados.

Cuando la radiación electromagnética escapó, unos cuantos cientos de miles de años después del comienzo de la expansión, era muy similar a la luz del Sol. Pero desde entonces, se ha desplazado al rojo debido a la expansión del universo, y se ha estirado hacia longitudes de onda más grandes, convirtiéndose en microondas.

Ahora, todo el universo está lleno de esta radiación, como un horno microondas, pero muy frío. Cuando usamos radio-teslescopios para observar el fondo cósmico de microondas, estamos observando una imagen directa del mismo Big Bang, pero muy desplazada al rojo. La luz de esta “foto” que tomamos hoy en día se emitió hace 13 500millones de años.

Naturalmente, este conocimiento del fondo cósmico de microondas no surgió de repente. Siguiendo el descubrimiento de la radiación de fondo en la década de 1960, fue estudiado usando primero radiotelescopios terrestres, y más tarde usando satélites diseñados específicamente para su observación.

Ha sido sólo en los diez últimos años cuando los estudios más detallados del fondo cósmico de microondas que han sido realizados con satélites, han mostrado que esta radiación no es perfectamente uniforme, y se ha usado para conocer un poco más acerca de la naturaleza del universo en el que vivimos, y de dónde vienen las galaxias.

Justo antes de que el universo alcanzara la temperatura para que la radiación y la materia dejaran de interaccionar, éstos estaban fuertemente “unidos”, como leche dispersa en una taza de té.

Donde la materia era un poco menos densa que la media, la radiación pudo enfríarse un poco, pero donde era más densa no. Así, estas diferencias en la temperatura quedaron impresas en la radiación, justo después de que ésta se desacoplara de la materia, y al mismo tiempo la materia comenzó a condensarse bajo la influencia de la gravedad, colapsando en planos y filamentos dentro de los cúmulos de galaxias que se formaron.

Llevando un poco más allá la analogía, es como si la leche formase grumos en el té, en vez de dispersarse uniformemente. Si el universo fue perfectamente uniforme cuando la materia y la radiación se desacoplaron, entonces, el fondo cósmico de microondas sería perfectamente uniforme hoy en día. Pero nadie lo podría observar actualmente, ya que en tal caso, la materia no habría colapsado nunca para formar galaxias y nosotros no estaríamos aquí.

Las fluctuaciones necesarias son tan pequeñas, que durante mucho tiempo se pensó que parecía improbable que pudieran ser medidas alguna vez. Cuando los satélites fueron lo suficientemente sofisticados, en la primera década del siglo XXI, encontraron que la temperatura media del fondo cósmico de microondas es 2,725 K, y cuyas fluctuaciones están entre 2,7249 y 2,7251 K.

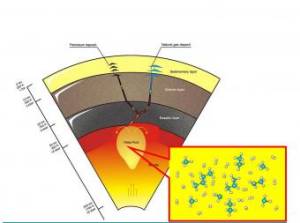

MATERIA OSCURA

Esto puede parecer casi insignificante, pero de hecho, detallados estudios del fondo cósmico de microondas muestran exactamente que el patrón de las fluctuaciones en la temperatura coincide con el de las variaciones de densidad que llevarían a formar el tipo de estructuras que observamos en el universo.

Pero se necesita un elemento más para formar las galaxias. Tiene que haber mucha materia oscura en el universo para explicar la naturaleza de las galaxias como la Vía Láctea.

Incluso se necesita más materia oscura todavía para explicar por qué los cúmulos de galaxias se mantienen unidos. Los cúmulos de galaxias son como enjambres de abejas, donde cada elemento del cúmulo se mueve dentro del cúmulo bajo la influencia de la gravedad, mientras que todo el cúmulo se mueve como un todo, debido a la expansión del universo.

Midiendo las velocidades de las galaxias individuales dentro de los cúmulos, usando el efecto Doppler, se obtiene mediante cálculos directos cuánta masa tiene que haber en el cúmulo para evitar que las galaxias se escapen. Esta cantidad es siempre mucho mayor que la cantidad de materia que podemos observar en las galaxias brillantes en el cúmulo.

El fondo cósmico de microondas nos dice lo mismo de forma independiente.

Simulaciones por ordenador de cómo las estructuras se forman el universo a medida que éste se expande, muestran que el patrón de galaxias y cúmulos que observamos sólo puede haberse formado a partir de fluctuaciones del tamaño de las que vemos en el fondo cósmico de microondas si hay cerca de seis veces más materia oscura que materia bariónica (materia atómica). Entonces, todo encaja perfectamente.

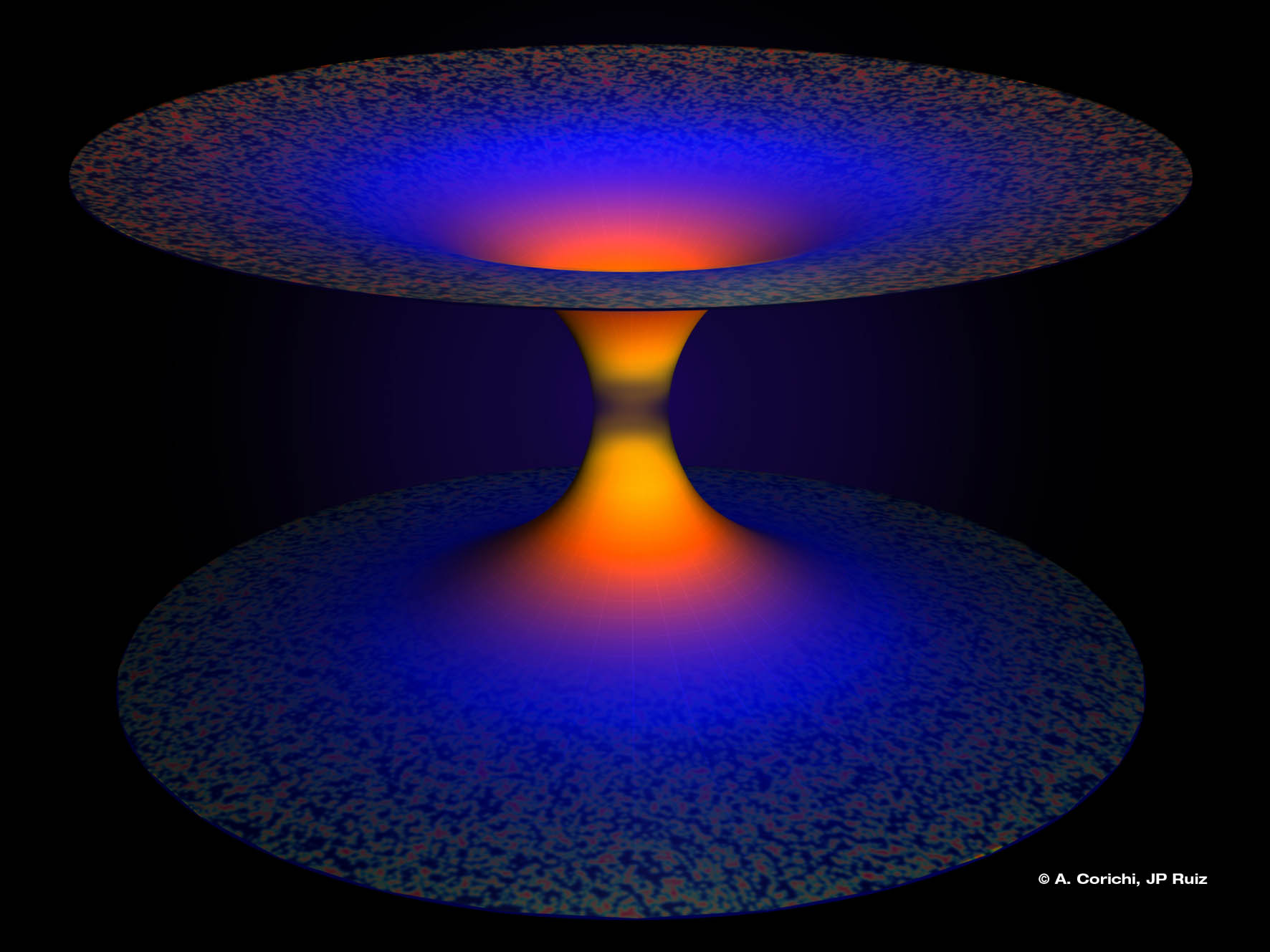

Pero aún así, éste no es el final de la historia de lo que podemos aprender del fondo cósmico de microondas. En la década 1930, poco después de que la expansión del universo fuese descubierta, los cosmólogos empezaron a preguntarse si la expansión duraría para siempre, o si por el contrario, se frenaría en algún momento, e incluso, que pudiera invertirse alguna vez. La respuesta depende de la curvatura del espacio, de acuerdo a cómo se define en la teoría de la relatividad general.

Hay tres posibilidades. Si hay más densidad de materia-energía que un determinado valor, el espacio tridimensional está curvado de la misma forma que una la superficie de una esfera, y entonces, el universo no tiene bordes.

En tal situación, si caminas en una dirección el tiempo suficiente, terminarás donde empezaste, como si lo hicieras en la superficie de la tierra.

Éste tipo de universo se denomina “cerrado”, y si el universo real es así, se expandirá durante un período de tiempo, se frenará debido a la gravedad, y terminará colapsando sobre sí mismo. Como un balón lanzado en el aire hacia arriba.

En el otro extremo, si hay menos densidad que el anterior valor determinado, el universo es abierto, y se expandirá para siempre. Como una nave espacial lanzada con suficiente velocidad, que escapará del campo gravitatorio terrestre.

La geometría es difícil de visualizar en este caso, pero es el equivalente tridimensional de la superficie de “una silla de montar”, o un paso de una montaña, extendiéndose al infinito en todas las direcciones.

En el medio de los dos extremos, se encuentra el espacio plano en tres dimensiones, como una hoja de papel en dos dimensiones.

Si el universo es así, seguirá expandiéndose a una velocidad cada vez menor, hasta llegar al borde del colapso, pero sin llegar realmente a colapsar. Al menos, ése se pensaba que sería el destino de un universo plano.

ENERGÍA OSCURA

Ahora, los cosmólogos tienen otra idea. Si el espacio estuviera curvado, curvaría la trayectoria de la luz, como una lente. Así, las imágenes de objetos muy distantes y el patrón de fluctuaciones del fondo cósmico de microondas estarían distorsionados de una determinada forma si el universo fuese cerrado y de otra bien distinta si fuese abierto.

Las observaciones no revelan ninguna señal de tales distorsiones, así que los cosmólogos están seguros de que el universo es plano. Esto significa que tiene que haber una determinada cantidad de materia en el universo, que se traduce en una determinada densidad “ahora”. Pero la cantidad de materia (oscura y bariónica) en el universo proporciona sólo cerca del 27 % de esta densidad, que se denomina densidad crítica.

Así que las observaciones del fondo cósmico de microondas dicen que tiene que haber otra forma de materia-energía dominando el universo. Ésta se denomina energía oscura. Y como la materia (bariónica y oscura), afecta a la curvatura del espacio, y por tanto, a la forma en la que el universo se expande.

El hecho de que el espacio es plano, nos dice cuánta materia-energía tiene que haber en total; si hay un 27 % de materia, tiene que haber un 73 % de energía oscura.

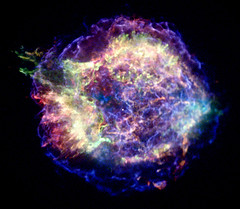

La energía oscura muestra su influencia en el universo directamente por la forma en que afecta a la expansión. Cuando las distancias a las galaxias distantes son medidas usando observaciones de explosiones de supernovas, se observa que dichas galaxias están un poco más lejos de nosotros de lo que debieran estar de acuerdo a la interpretación más simple de sus desplazamientos al rojo.

Todo encaja de nuevo, sin embargo, si la expansión del universo es acelerada, las galaxias distantes están un poco más lejos que lo que implica la ley de Hubble. El efecto es muy pequeño para ser medido observando galaxias cercanas, que es por lo que no fue detectado hasta el final del siglo XX.

Se piensa que la energía oscura actúa como una especia de antigravedad, estirando el espacio, y que este efecto será mayor a medida que el universo envejece – como las galaxias se alejan unas de otras, la gravedad entre ellas se debilita, pero la energía oscura continúa empujandolas.

Si éstas nuevas ideas son correctas, entonces el espacio siempre será plano, pero la expansión del universo será cada vez mayor, hasta que dentro de unos 100 000 millones de años a partir de ahora, las galaxias estarán tan lejos unas de otras que será imposible ver nada más allá de la Vía Láctea y el resto de galaxias que forman el lamado Grupo Local. Qué sucede después sólo podemos suponerlo.

Cómo empezó el universo también es algo que sólo podemos suponer; pero es asombroso cómo de lejos podemos ir en el tiempo antes de que los cosmólogos tengan que recurrir a una “suposición cualificada”.

Debido a que conocemos la temperatura del fondo cósmico de microondas hoy, y la densidad promedio del universo, y cómo de rápido el universo se está expandiendo, podemos ir atrás en el tiempo para deducir la temperatura y la densidad en cualquier instante del pasado.

Sabemos que el universo comenzó hace aproximadamente unos 14 000 millones de años en el Big Bang, y uno de los objetivos de la cosmología es deducir qué condiciones había tan cerca como sea posible del principio, al que se denomina a veces “tiempo cero”.

Las condiciones más extremas de densidad que existen hoy en la tierra se encuentran en los núcleos de de los átomos, y gracias a experimentos en grandes aceleradores de partículas, los físicos están seguros de que entienden profundamente la física de las densidades nucleares – y, por tanto, entienden al menos igual de bien, qué sucede a bajas densidades.

Si vamos hacia atrás en la expansión del universo hacia el instante en que la densidad en todas partes era del orden de la densidad del núcleo de un átomo hoy en día, nos iríamos a un diezmilésima de segundo después del tiempo cero. Los cosmólogos están seguros de que entienden, en términos generales, todo lo que ha sucedido en el universo desde entonces.

FORMACIÓN DE GALAXIAS

En ese instante, la temperatura del universo era de un billón de Kelvin, y los fotones de lo que se convertiría después en el fondo cósmico de microondas llevaban tanta energía que eran intercambiables por partículas.

A medida que el universo se fue expandiendo y enfriando en los cuatro minutos siguientes, algunos de los fotones se condensaron en protones y neutrones, los elementos constitutivos de los núcleos atómicos, mientras que la temperatura seguía disminuyendo.

Un cuarto de esas partículas terminaron como núcleos de helio, y el resto permanecieron como protones y núcleos de hidrógeno. Pero todavía, la temperatura era muy alta como para que dichos núcleos atrajeran a los electrones, volviéndose átomos neutros; durante un tiempo los electrones continuaron interactuando con la radiación.

Llevó entre 300 000 y 400 000 años que la temperatura del universo cayera por debajo de la temperatura en la superficie de una estrella, momento en el cual los fotones pudieron desacoplarse de la materia y se volvieron la radiación de fondo que observamos hoy en día en la región de las microondas.

Durante todo este tiempo, la materia bariónica estuvo sumergida en el mar de materia oscura, que no interacciona con la radiación. Pequeñas irregularidades en la distribución de materia oscura produjeron regiones de mayor densidad, mientras que la gravedad atrajo tanto a la materia oscura como a la bariónica, condensándose, y uniéndose estas concentraciones a lo largo de filamentos de materia oscura como cuentas en una cuerda. Estas condensaciones atrajeron más materia gracias a su gravedad, como el agua fluyendo hacia un hoyo en un camino.

Alrededor de 20 millones de años después del tiempo cero, los “hoyos” de materia oscura fueron atrayendo corrientes de materia bariónica, que formaron estrellas y galaxias a medida que se iba condensando por efecto de la gravedad de la materia oscura.

EL MULTIVERSO

Casi después de más de mil millones de años desde el tiempo cero, menos de una décima parte de la edad actual del universo, había junto con muchas galaxias pequeñas, algunas proto-galaxias tan grandes como la Vía Láctea, embebidas en halos de materia oscura conteniendo del orden de un billón de masas solares de materia, con cuásares u otras formas de actividad de agujeros negros en sus centros.

Desde entonces, las galaxias crecieron y evolucionaron a través de procesos de “fusión”, como describimos anteriormente. Las fusiones son interacciones gravitatorias entre dos o más galaxias a través de las cuales las galaxias terminan formando una sola.

Pero los cosmólogos no están contentos con conocer cómo el universo se ha desarrollado desde 0,0001 segundos después del tiempo cero. Quieren conocer también lo que sucedió antes. Y aquí es dónde “el trabajo de suposición cualificada” entra en juego, y no hay una teoría o modelo único, con el que todo el mundo esté de acuerdo.

Qué modelo prefiere cada uno depende de su gusto personal, y como nosotros no tenemos suficiente espacio para discutirlos todos, describiremos el que más nos gusta.

De acuerdo con este modelo, todo el universo que vemos es tan sólo una parte de una burbuja dentro de una región más grande del espacio-tiempo. Éste puede ser literalmente infinito en el espacio y en el tiempo; para distinguirlo de lo que denominamos usualmente con el termino universo, es llamado a veces cosmos, y la implicación es que pueden haber otros universos burbuja esparcidos a lo largo del cosmos como burbujas hay en una bebida gaseosa.

Si el cosmos es infinito en el tiempo, significa que siempre ha existido y siempre existirá, y que no hay ni un principio ni un final del tiempo del que preocuparnos. Si es infinito en el espacio, significa que se extiende para siempre en todas las direcciones y no hay bordes de los que preocuparse.

INFLACIÓN

Todo esto es relativamente simple de describir en términos matemáticos, y una característica de tal descripción es que las ecuaciones nos dicen que es posible que las fluctuaciones cuánticas produzcan pequeñas burbujas dentro del espacio-tiempo del cosmos.

La física cuántica es una rama de la física que describe lo que sucede en la escala de los átomos y las partículas fundamentales. Como esas fluctuaciones cuánticas son mucho más pequeñas que un átomo, podrían no tener mucho en común con un universo tan grande como el nuestro, que ha estado expandiéndose durante cerca de 14 000 millones de años y que contiene cientos de miles de millones de galaxias.

Pero al principio de la década de 1980, el teórico Alan Guth se dio cuenta de que hay una forma de hacer que una de esas fluctuaciones cuánticas se expandan muy rápido durante un período muy corto de tiempo, creciendo hasta convertirse en una semilla del Big Bang.

El proceso se denomina inflación, y funciona exactamente de la misma forma en la que la energía oscura acelera la expansión del universo, pero más violentamente.

La energía oscura asociada con la inflación pudo tomar una fluctuación cuántica aproximadamente 10 trillones de veces más pequeña que un proton e inflarla en una región de unos 10 centímetros de diámetro en una pequeña fracción de segundo.

Después, Guth mostró que la energía oscura se convierte en la energía de una “bola de fuego caliente”, expandiéndose tan rápidamente después del estallido inicial que incluso aunque la gravedad comenzase inmediatamente después a detener la expansión, tardaría en pararla cientos de miles de millones de años.

La inflación trae consigo un regalo. Durante ese primer instante, el que es ahora nuestro universo visible habría duplicado su tamaño cien veces. Esto tendría el efecto de suavizar cualquier irregularidad, del mismo modo que la superficie rugosa de una ciruela se suaviza cuando es introducida en agua y se hincha.

La inflación hace también el espacio muy pero que muy plano, como lo observamos en el universo real. La superficie de la tierra ya parece muy plana, aunque sabemos que vivimos en la superficie de una esfera. Imagina duplicar el diámetro de la esfera cien veces; duplicar su tamaño una vez la hace dos veces más grande, duplicarla dos veces la hace cuatro veces más grande, duplicarla tres veces la hace ocho veces más grande, y así sucesivamente.

Finalmente, duplicarla cien veces, la hace 2100 veces más grande. Sería casi imposible para las personas que viven en la superficie de una esfera tan grande decir si la superficie tiene curvatura o no. De acuerdo con muchas observaciones, sería indistinguible de una superficie plana.

La inflación predice que el universo debería ser plano, en el sentido ya descrito, y que debería contener sólo pequeñas irregularidades en el instante del Big Bang. Éstas son exactamente el tipo de pequeñas irregularidades que vemos en el fondo cósmico de microondas, que nosotros sabemos que son del tamaño adecuado para la existencia de las galaxias.

La impresionante consecuencia de la teoría de la inflación es que las galaxias existen (y por tanto, los planetas y las personas) gracias a las fluctuaciones cuánticas que fueron dejadas cuando todo el universo que observamos a nuestro alrededor era más pequeño que un átomo.

La inflación es una explicación tan satisfactoria de la forma en la que el Big Bang empezó, que está incluída en casi todas las ideas modernas sobre cómo nació el universo, no sólo el modelo de Cosmos eterno que a nosotros nos gusta en particular.

El gran debate en cosmología ahora se centra en la forma en la que comenzó la inflación, pero la enorme expansión del universo durante la inflación suavizó tanto la información de lo que ocurrió antes, que puede que nunca sepamos cómo empezó exactamente el universo.

Puede ser, sin embargo, que la inflación esté conectada con el destino del universo, así como con su origen. Cuando la energía oscura en su forma habitual haya realizado su trabajo, mucho después de que las galaxias se hayan alejado tanto unas de otras que sean invisibles entre ellas, la energía oscura desgarrará la estructura de la materia misma y producira el vacío final.

Éstas son las condiciones ideales para los tipos de fluctuaciones cuánticas que se han conectado con el nacimiento de nuestro universo. Puede ser que la muerte de nuestro universo lleve al nacimiento de otros universos, y que nosotros seamos sólo un eslabón de una cadena cósmica de universos extendiéndose infinitamente tanto en el espacio como en el tiempo hacia el pasado y hacia el futuro. Otra idea es que cada fluctuación cuántica produce un “universo burbuja” diferente.

Esta imagen tan sobrecogedora nos hace parecer muy insignificantes a escala cósmica. Pero poniendo esta especulación aparte, volviendo a la Tierra y concentrándonos en nuestro propio universo, encontramos que hay íntimas conexiones entre la vida y el universo.

Autor: John Gribbin / Mary Gribbin

Fecha Original: 13 de mayo de 2009

Enlace Original